SoundNet: Learning Sound Representations from Unlabeled Video[Aytar et al. NIPS2016]

SoundNet: Learning Sound Representations from Unlabeled Video[Aytar et al. NIPS2016] の簡単にまとめ.

詳しくはこちらへ 著者のAntonio TorralbaさんはMultimedia界隈でありえん有名らしい

SoundNet: Learning Sound Representations from Unlabeled Video - MIT

目的

- 音声表現を学習するために,自然なunlabeledな動画(画像と音声)の相関を学習すること.

- エモいpretrained model作る.

2 Large Unlabeled Video Dataset

3 Learning Sound Representations

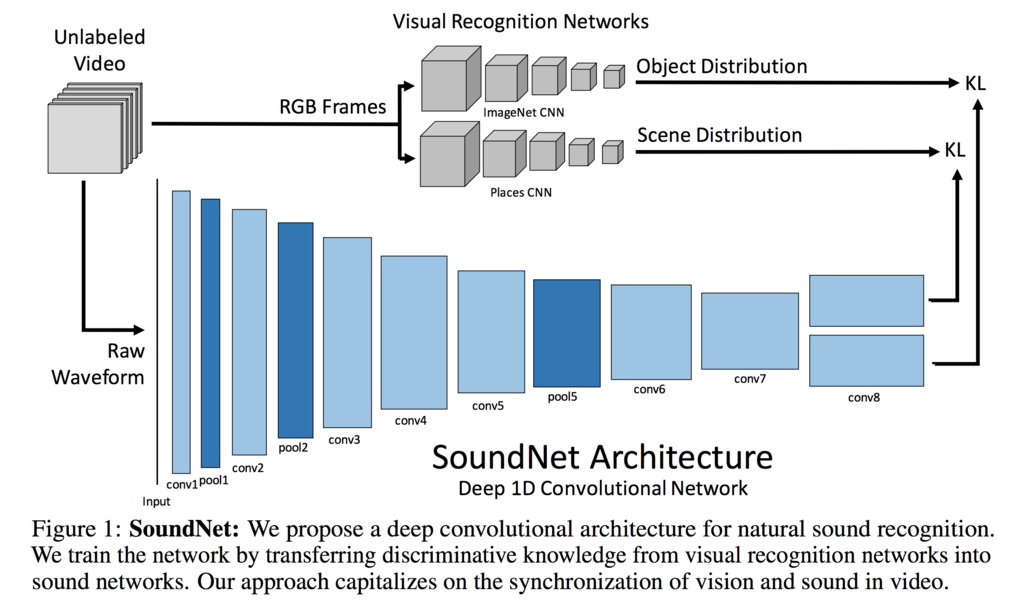

3.1 Deep Convolutional Sound Net

CNN

- 1DConv使用

Variable Length Input/Output

- 長さは様々なので色々扱いたい

- inputの長さによって特徴は変わるので,様々なinputの長さでうまくいくoutput layersを設計せなあかん.

- global poolingだと特徴を破棄してしまうことがある.

- 目的はビデオでtrainするので,Conv使うよん

Network Depth

- overfitting怖い

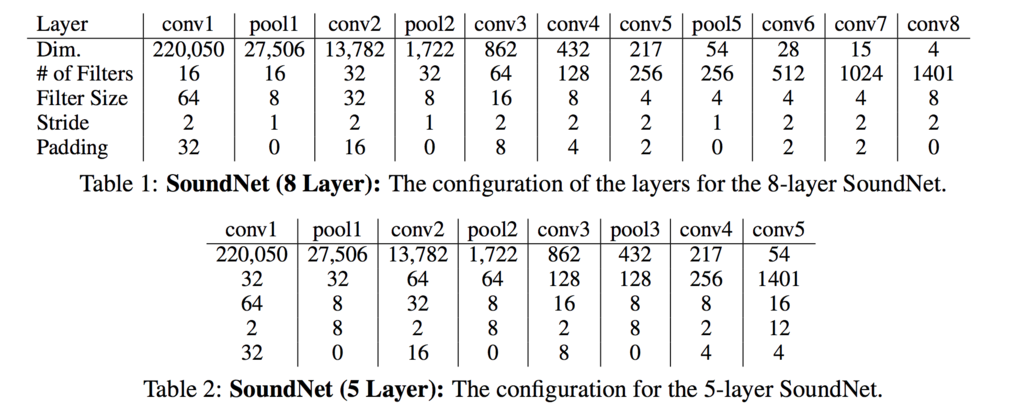

- conv8層, pooling3つにした. conv5層と比較して良いと判断したから.

3.2 Visual Transfer into Sound

- student-teacherモデルでやる

- visionがネットワークに音声がオブジェクトやシーンを認識するために教える.

- KL距離を最小化するように学習

3.3 Sound Classification

- output layerではなく,中間層の情報を使うのと,線形SVMを学習する.

3.4 Implementation

- Adam,beta1=0.001, beta2=0.9

- batch size 64

- 初期値はmean gaussian noise 0.01

- convの後にはbatch norm, ReLU.

- 100,000 iterations.

4 Experiments

Experimental Setup

- train 2m, test 140k

Baselines

- conv4, deconv4のautoencoderみたいにした.

- MSELoss

4.1 Acoustic Scene Classification

- DCASE Challenge, ESC-50, ESC-10 datasetsを使用

DCASE

- Detection and Classification of Acoustic Scenes and Events Challengeの略

- 音声からシーンを認識する

- 10 acoustic scene categoryがある

- 各カテゴリーに10 training example,100 test exampleがある

- 30s

ESC-50 and ESC-10

- ESC-50は,5メジャーグループ(animal, natural soundscape, human non speech sound, interior/domestic sounds and exterior/urban noise)50カテゴリー5s の音.

- 当時のSoTAは81.3%

- 各カテゴリ40 samples

- ESC-10は10クラス(dog bark, rain, sea waves, baby cry, clock tic, person sneeze, helicopter, chainsaw, rooster and fire cracking)

- 当時のSoTAは95.7%

- 結果は下の図みて

Conclusion

- unlabeled datasetで学習して識別するモデルを作った

感想

- 雑ですが,細かい議論を見るには論文を読んで方が早いです.

- 音声もやっぱConvなんだ

- fine tuningはしてなさそうだし,このモデルが大規模pretrained modelとなったのか

- 画像と音声の距離を近づけるためにKL距離を使っていてなるほどなってなった

- ObjectとSceneは分けた方がいいのか?ここら辺がわからなかた

- 結果で,conv6の特徴量が一番精度高くなってて,conv7,8だと急激に落ちてるのはなぜだ?